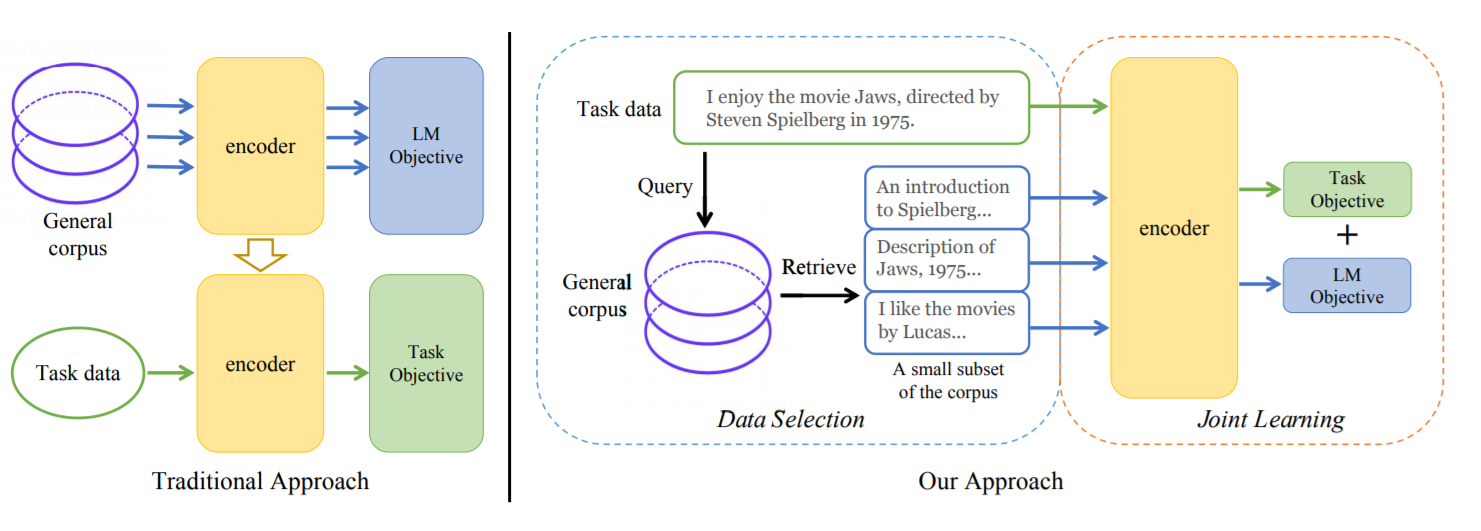

NLP From Scratch Without Large-Scale Pretraining: A Simple and Efficient Framework

提出了一种简单有效的学习框架TLM,其不需要大规模的预训练。

《自然语言处理入门》思维导图

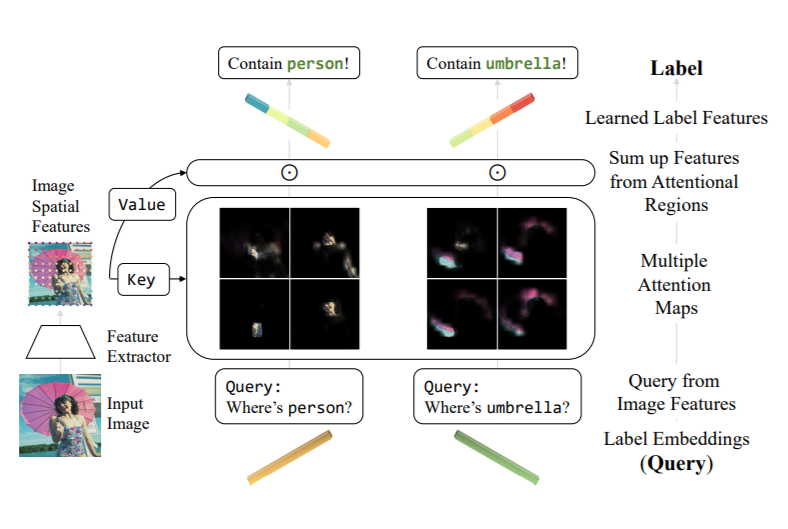

来自清华-博世机器学习研究中心,将Transformer解码器用于多标签分类,将label embedding作为query,计算与feature map的cross-attention。在MS-COCO、PASCAL VOC、NUS-WIDE和Visual Genome上进行了实验,取得了SOTA结果。